随机梯度下降如何应用于优化问题?

31

2024-07-06

一、介绍随机梯度下降(Stochastic Gradient Descent,简称SGD)是一种常用于优化问题的算法。它在机器学习领域广泛应用于线性回归、支持向量机和神经网络等模型的训练过程中。本文将详细介绍随机梯度下降的原理以及在优化问题中的应用。二、梯度下降算法在了解随

一、介绍

二、梯度下降算法

在了解随机梯度下降之前,首先需要了解梯度下降算法。梯度下降是一种迭代优化算法,通过更新模型参数来最小化损失函数。算法的核心思想是在每一次迭代中,根据负梯度方向进行参数更新,直到达到最小化损失函数的目标。三、随机梯度下降原理

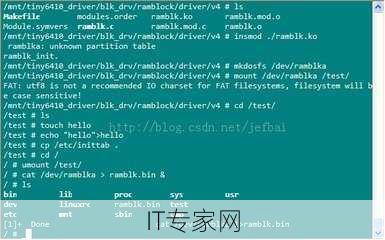

与标准梯度下降不同,随机梯度下降每次只使用一个样本计算梯度并更新参数,而不是使用整个训练集。这种随机性使得算法具有更快的收敛速度,并且对大规模数据集特别有效。 随机梯度下降算法可以描述为以下几个步骤:- 随机初始化模型参数。

- 对于训练数据集中的每个样本,计算模型关于该样本的梯度并更新参数。

- 重复第二步直到达到停止条件。

四、优点和缺点

随机梯度下降具有以下优点:- 收敛速度快:由于每次只使用一个样本进行更新,所以算法的迭代速度明显比标准梯度下降快。 ```python # 随机梯度下降示例代码 import random def sgd_optimization(x, learning_rate, epochs): w = random.random() # 随机初始化模型参数 for epoch in range(epochs): for xi, yi in zip(x, y): gradient = compute_gradient(w, xi, yi) # 计算梯度 # 更新参数 w = w - learning_rate * gradient return w ```

- 内存要求低:相比使用整个训练集计算梯度,随机梯度下降在内存消耗方面更加高效。

- 适用于大规模数据集:由于只使用一个样本进行更新,因此随机梯度下降在处理大规模数据集时更具优势。

- 收敛性不稳定:由于随机性的引入,随机梯度下降可能会在全局最优解附近摆动,并且不容易达到最优解。

- 更新方向不一定准确:单个样本的梯度并不一定能准确反映整体数据的趋势,导致更新方向可能存在误差。

五、应用案例

随机梯度下降算法广泛应用于机器学习领域的各种模型训练中,其中包括但不限于以下应用案例:- 线性回归:使用随机梯度下降可以有效地拟合线性模型,并找到最优的模型参数。

- 支持向量机:在支持向量机模型中,随机梯度下降被用来寻找最大边界的分类器。

- 神经网络:由于神经网络通常具有大规模的数据和参数集,使用随机梯度下降可以更快地收敛并减少内存消耗。

六、总结

随机梯度下降是一种常用的优化算法,在解决大规模数据集和高维参数的优化问题时表现出色。尽管存在收敛性不稳定和更新方向不准确等缺点,但通过合理设置学习率和迭代轮数等超参数,可以充分发挥随机梯度下降的优势。在实际应用中,需要根据具体问题和数据集的特点选择合适的优化算法。